ICLR 2020 | 如何让图卷积网络变深?腾讯AI Lab联合清华提出DropEdge

机器之心编辑部

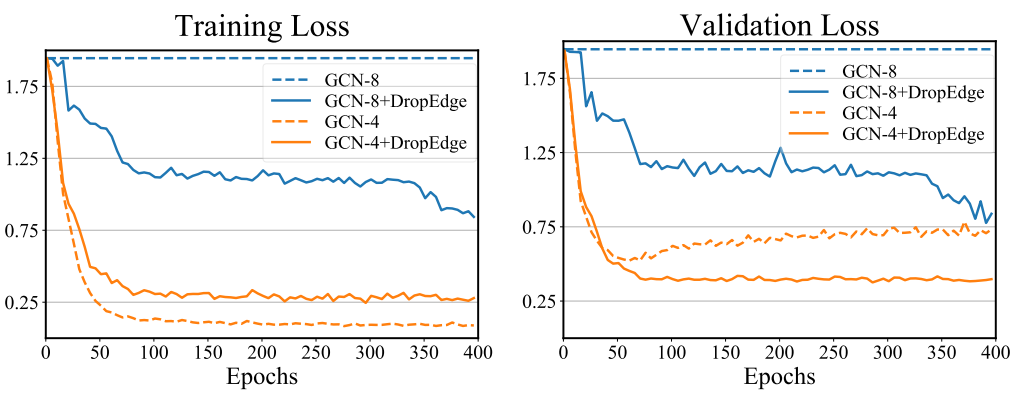

近年来,图神经网络的研究异常火爆,被各大顶会录取的文章数量爆炸式增长。然而,目前大部分图卷积网络,尤其是面向节点分类的网络,都是浅层网络。这些模型分类效果往往随着深度加深而变差(即使使用残差连接),这与用于图片分类的卷积网络动辄超过几十层的现象很不一致。图卷积神经网络变深之后难以训练的现象严重制约了其表达能力。所以,如何有效的训练超深图卷积网络是图学习研究的一个重大挑战。这项工作由腾讯 AI Lab 与清华大学合作完成。

论文地址:https://openreview.net/forum?id=Hkx1qkrKPr

代码地址:https://github.com/DropEdge/DropEdge

的信息损失。基于此,文章设计了一种非常简单但是有效的方法 DropEdge。在每轮训练的时候,DropEdge 会随机去掉输入的图上的边,即会将邻接矩阵

的信息损失。基于此,文章设计了一种非常简单但是有效的方法 DropEdge。在每轮训练的时候,DropEdge 会随机去掉输入的图上的边,即会将邻接矩阵 中

中 的非零元素置 0,

的非零元素置 0, 是删边概率。如果用

是删边概率。如果用 表示 DropEdge 后的邻接矩阵,则

表示 DropEdge 后的邻接矩阵,则 ,

, 是被去掉的边的邻接矩阵。在得到

是被去掉的边的邻接矩阵。在得到 后,对其进行正则化得到

后,对其进行正则化得到  代替

代替 进行计算。

进行计算。 在进行 GCN 计算中可以减弱过平滑对模型的影响,即:

在进行 GCN 计算中可以减弱过平滑对模型的影响,即:

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

赞助链接

排名

热点

搜索指数

- 1 习近平结束国事访问回到北京 4903338

- 2 秦岭已发现11次棕色大熊猫 4994497

- 3 五月天假唱风波调查结果终于出了 4886989

- 4 中塞“钢杆”友谊的炼成密码 4791327

- 5 官方号还是到00后手里了 4613544

- 6 一季度地区经济开局有力 4550098

- 7 日本可口可乐公司宣布涨价 4431317

- 8 46岁茶农上山采茶被野狗咬伤身亡 4382682

- 9 湖北居民用电将分段计价?不实 4236123

- 10 宠物有望上高铁惹争议 4189164

![何丹彤 大小盆友节日快乐哦[耶]](https://imgs.knowsafe.com:8087/img/aideep/2022/1/9/1cf144738ac1181894447824a15c7a14.jpg?w=250)

![林津伊 [喵喵]没事的时候就拍拍照吧[doge][doge][doge][doge] ](https://imgs.knowsafe.com:8087/img/aideep/2022/6/15/64b976e0efa4fe02e70f423a77416ed5.jpg?w=250)

![是小圆圈:天气很好 心情很好[太阳] ](https://imgs.knowsafe.com:8087/img/aideep/2021/7/1/9ac013342a551d6affffb27519dd8f1c.jpg?w=250)

机器之心

机器之心