多语言互通:谷歌发布实体检索模型,涵盖超过100种语言和2000万个实体

新智元报道

新智元报道

编辑:QJP

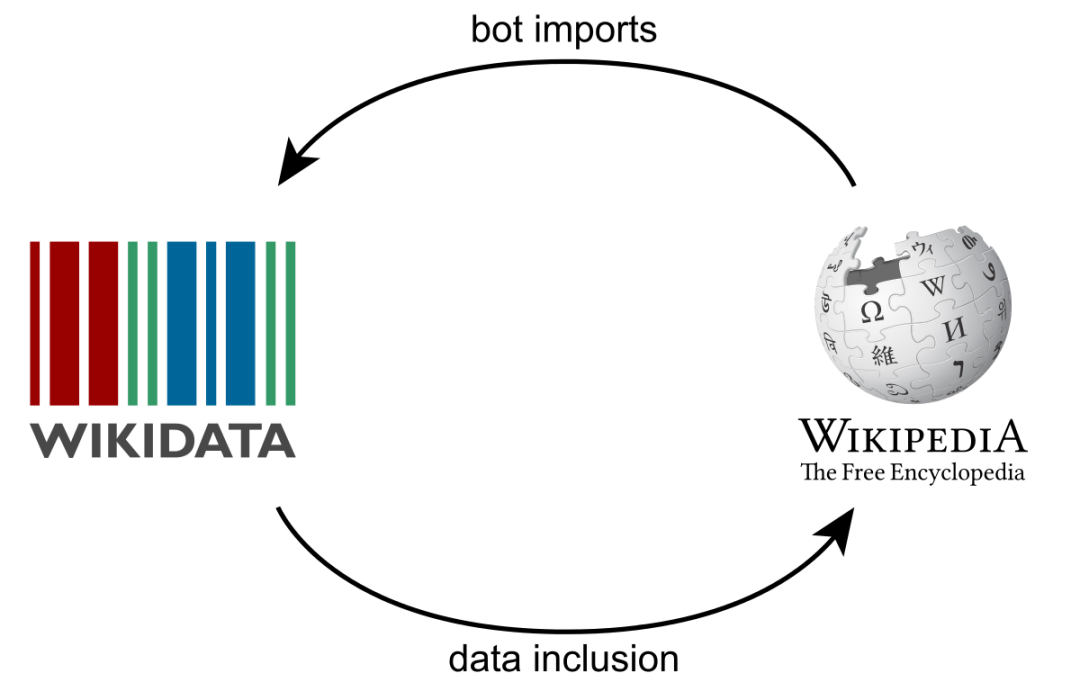

【新智元导读】实体链接(Entity linking)通常在自然语言理解和知识图谱中起着关键作用。谷歌AI研究人员近期提出了一种新的技术,在这种技术中,可以将特定语言解析为与语言无关的知识库。

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

赞助链接

排名

热点

搜索指数

- 1 习近平会见美国国务卿布林肯 4907112

- 2 双休政策参与者谈调休 4958191

- 3 王婆江西说媒被彩礼震惊?本人回应 4851824

- 4 神舟起大漠 逐梦叩苍穹 4769820

- 5 微信发文件3小时内可撤回 4675981

- 6 带50余名员工集体跳槽 3人被刑拘 4516485

- 7 余华建议女学生结婚要找江浙男 4453493

- 8 比尔·盖茨在人民日报撰文 4314250

- 9 网约车被路政追赶致2死1伤不实 4236893

- 10 山寨兵马俑景区荒废近2年 老板去世 4125781

新智元

新智元