AI碰上《如梦令》?中文NLP大赛正在进行中

机器之心发布

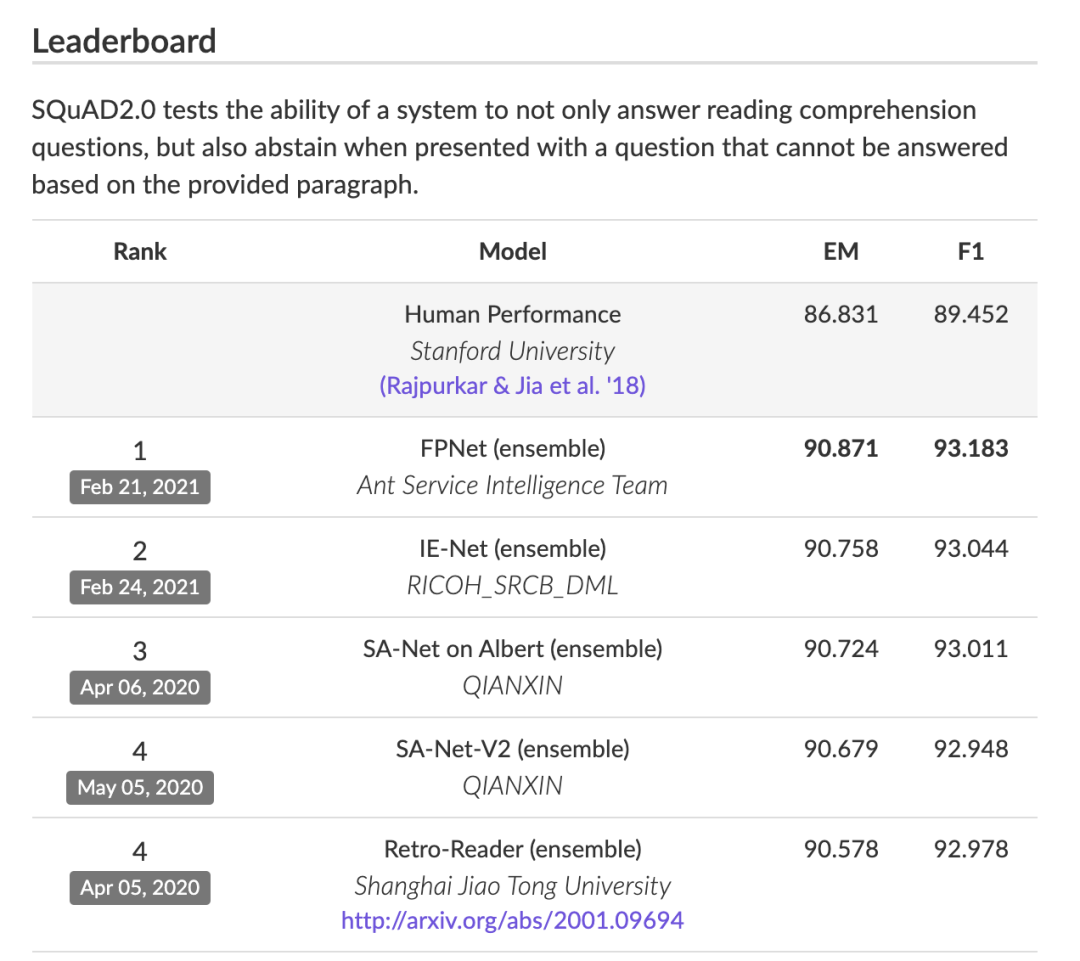

「2021 海华 AI 挑战赛 · 中文阅读理解」正在进行,旨在推动机器阅读理解综合水平的提高和综合能力的拓展,为中文阅读理解在教育、医疗、金融等各个领域的应用提供参考。

Hermann, Karl Moritz, Tomáš Kočiský, Edward Grefenstette, Lasse Espeholt, Will Kay, Mustafa Suleyman, and Phil Blunsom. "Teaching machines to read and comprehend." arXiv preprint arXiv:1506.03340 (2015).

Rajpurkar, Pranav, Jian Zhang, Konstantin Lopyrev, and Percy Liang. "Squad: 100,000+ questions for machine comprehension of text." arXiv preprint arXiv:1606.05250 (2016).

Rajpurkar, Pranav, Robin Jia, and Percy Liang. "Know what you don't know: Unanswerable questions for SQuAD." arXiv preprint arXiv:1806.03822 (2018).

Welbl, Johannes, Pontus Stenetorp, and Sebastian Riedel. "Constructing datasets for multi-hop reading comprehension across documents." Transactions of the Association for Computational Linguistics 6 (2018): 287-302.

Nguyen, Tri, Mir Rosenberg, Xia Song, Jianfeng Gao, Saurabh Tiwary, Rangan Majumder, and Li Deng. "MS MARCO: A human generated machine reading comprehension dataset." In CoCo@ NIPS. 2016.

He, Wei, Kai Liu, Jing Liu, Yajuan Lyu, Shiqi Zhao, Xinyan Xiao, Yuan Liu et al. "Dureader: a chinese machine reading comprehension dataset from real-world applications." arXiv preprint arXiv:1711.05073 (2017).

Lai, Guokun, Qizhe Xie, Hanxiao Liu, Yiming Yang, and Eduard Hovy. "Race: Large-scale reading comprehension dataset from examinations." arXiv preprint arXiv:1704.04683 (2017).

Sun, Kai, Dian Yu, Jianshu Chen, Dong Yu, Yejin Choi, and Claire Cardie. "Dream: A challenge data set and models for dialogue-based reading comprehension." Transactions of the Association for Computational Linguistics 7 (2019): 217-231.

Ostermann, Simon, Ashutosh Modi, Michael Roth, Stefan Thater, and Manfred Pinkal. "Mcscript: A novel dataset for assessing machine comprehension using script knowledge." arXiv preprint arXiv:1803.05223 (2018).

Reddy, Siva, Danqi Chen, and Christopher D. Manning. "Coqa: A conversational question answering challenge." Transactions of the Association for Computational Linguistics 7 (2019): 249-266.

Dua, Dheeru, Yizhong Wang, Pradeep Dasigi, Gabriel Stanovsky, Sameer Singh, and Matt Gardner. "DROP: A reading comprehension benchmark requiring discrete reasoning over paragraphs." arXiv preprint arXiv:1903.00161 (2019).

https://www.zhihu.com/question/59227800

Zheng, Chujie, Minlie Huang, and Aixin Sun. "Chid: A large-scale chinese idiom dataset for cloze test." arXiv preprint arXiv:1906.01265 (2019).

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 逐梦苍穹 习近平引领航天强国建设 4901923

- 2 神十八发射取得圆满成功 4998776

- 3 职高女孩逆袭成双一流大学研究生 4855966

- 4 解码首季经济成绩单 4758701

- 5 14岁男孩离家出走 一夜骑了60公里 4604229

- 6 女子火车上如厕时130g黄金掉落铁轨 4518882

- 7 神十八点火瞬间航天员齐刷刷敬礼 4482413

- 8 老人被宠物狗撕咬 手中握刀不舍得砍 4324344

- 9 深圳部分区域将取消限购不实 4223079

- 10 与朋友爬山失联女子已找到 丈夫回应 4127078

机器之心

机器之心