Transformer变体为何无法应用于多种任务?谷歌:这些架构更改不能有效迁移

来自 Google Research 的研究人员探索了多个 transformer 变体,发现它们无法在多个实现和应用中实现很好地迁移,大多数架构更改无法有效提升性能。

透明注意力:沿着编码器路径创建加权残差连接,以加速梯度流;

进化 Transformer:通过基于进化的架构搜索来设计模型,其中初始群体的种子是原版 transformer;

合成器变体:用「合成注意力」替代自注意力;

漏斗 Transformer:渐进式地减少序列长度,以高效编码输入序列;

稀疏专家 Transformer:用稀疏激活专家层替代前馈网络;

通用 Transformer:对输入序列重复应用相同的 transformer「模块」。

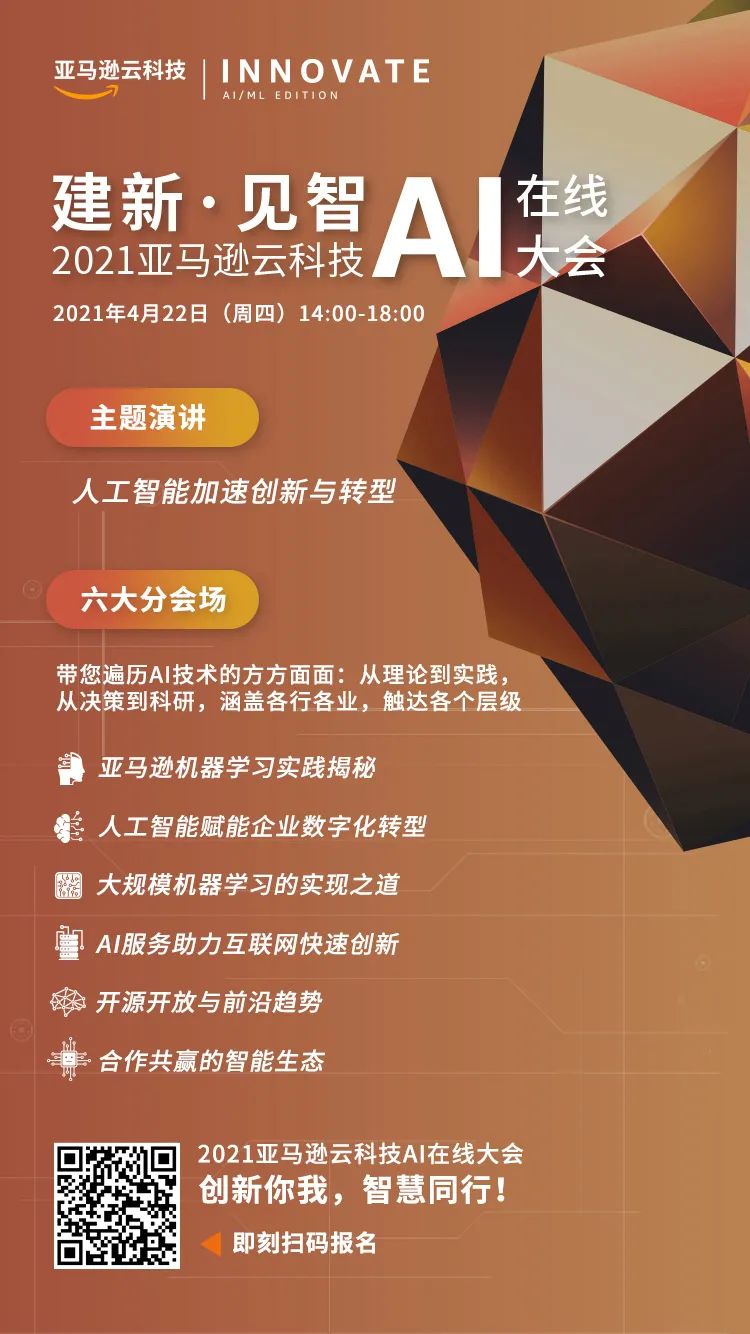

建新·见智 —— 2021亚马逊云科技 AI 在线大会

4月22日 14:00 - 18:00

识别二维码或点击阅读原文,免费报名看直播。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

赞助链接

排名

热点

搜索指数

- 1 中国人民解放军信息支援部队成立 4997022

- 2 男子给27万彩礼订婚后准新娘自尽 4948213

- 3 韩国人泰国被抓谎称是中国人 4807705

- 4 春茶春菜春耕 4727973

- 5 越南女首富被判死刑后引“寻宝热” 4689695

- 6 央媒发文:放假绝不是假放 4574842

- 7 美国学生庆祝逃学日遭枪击 4474718

- 8 闲鱼出现大量转卖SU7创始车型订单 4332992

- 9 淄博赵大爷辟谣收徒弟要收钱 4211124

- 10 日元贬值 海外游客涌入日本扫货 4130075

机器之心

机器之心