传统应用挂载对象存储,满足集群高并发的大数据分析场景

下载 JuiceFS

# curl -ssLhttps://github.com/juicedata/juicefs/releases/download/v0.11.0/juicefs-0.11.0-linux-amd64.tar.gz > juicefs.tar.gz# tar -xvf juicefs.tar.gz && cd juicefs

启动 Redis

# apt install redis

# systemctl status redis.service

创建 Volume

创建 Volume

# ./juicefs format \--storage qingstor \--bucket https://<bucket_name>.pek3b.qingstor.com \--access-key <access_key> \--secret-key <secret_key> \<redis-url> test

挂载 Volume

# ./juicefs mount -d <redis-url> ~/jfs

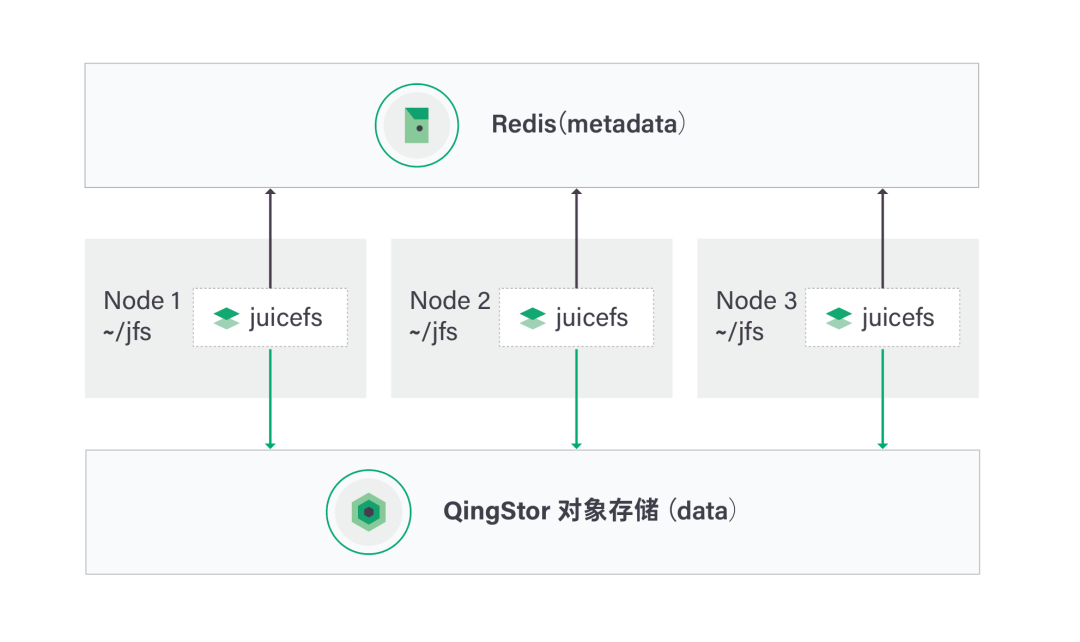

图 1 JuiceFS 集群架构图

测试一:在单个节点上创建文件

测试一:在单个节点上创建文件

root@i-8cvklc58:~/jfs# dd if=/dev/urandom of=example bs=1M count=10241024+0 records in1024+0 records out1073741824 bytes (1.1 GB, 1.0 GiB) copied, 42.1686 s, 25.5 MB/s

测试二:在不同的节点上并发创建文件

root@i-ywbaq5jc:~/jfs# dd if=/dev/urandom of=example1 bs=1M count=10241024+0 records in1024+0 records out1073741824 bytes (1.1 GB, 1.0 GiB) copied, 42.1694 s, 25.5 MB/s

root@i-8cvklc58:~/jfs# dd if=/dev/urandom of=example2 bs=1M count=10241024+0 records in1024+0 records out1073741824 bytes (1.1 GB, 1.0 GiB) copied, 42.1925 s, 25.4 MB/s

root@i-7gksnd1q:~/jfs# dd if=/dev/urandom of=example3 bs=1M count=10241024+0 records in1024+0 records out1073741824 bytes (1.1 GB, 1.0 GiB) copied, 42.1689 s, 25.5 MB/s查看 JuiceFS 写入的数据

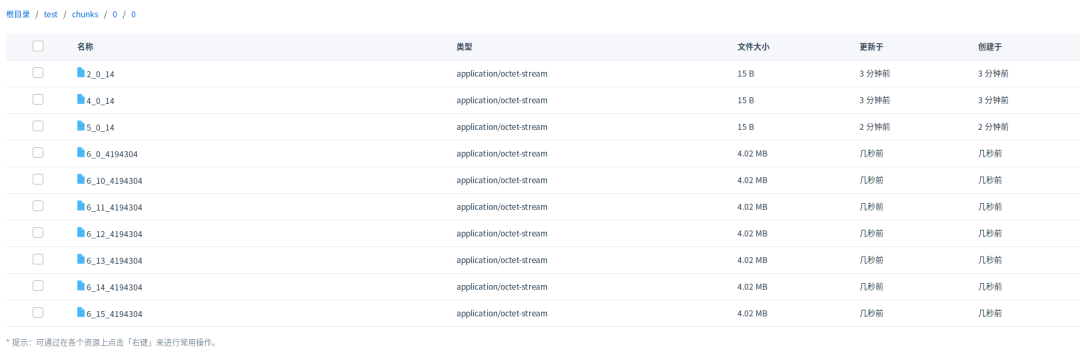

图 2 JuiceFS 写入的数据文件

3. More ...

- FIN -

相关文章推荐

点击了解JuiceFS

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

赞助链接

排名

热点

搜索指数

- 1 总书记的8次座谈和8次调研 4965536

- 2 王毅开场白提醒布林肯别踩红线 4962656

- 3 下一个被淘汰的电子产品是什么 4829554

- 4 让古建老宅活起来 4755122

- 5 丫丫回家一年从yy胖成YY 4628062

- 6 男子帮女子报警被砍断手筋 4537710

- 7 河南县城钻石卖得像白菜 4441262

- 8 失踪近一世纪名画拍出2.3亿 4388257

- 9 女生被造黄谣跳楼身亡?不实 4270009

- 10 韩企开始清退35岁以上员工 4188008

QingCloud

QingCloud