TeaTalk·Online 演讲实录|奥秘探寻!移动云·NFV,驰而不息

11月10日,TeaTalk· Online应用实战系列活动第3期——“新一代云网络NFV架构创新和探索 ”线上直播成功举办。本次直播我们跟随刘老师,让NFV技术与移动云碰了个满怀。通过了解了移动云如何融合NFV技术,不断精益求精、推陈出新,探寻了移动云NFV平台的规格性能及成本优势提升的奥秘。

以下为中国移动云能力中心NFV平台产品经理,刘欢欢老师的演讲实录。

随着公有云业务的快速发展,传统云网络NFV技术弹性不足、交付率低、开放性不足等问题日益凸显,无法满足公有云租户对网络流量的突发、弹性、大规模的需求,AWS、阿里云等头部厂商陆续发布了新一代云原生的NFV平台,移动云如何快速跟紧步伐,实现技术追赶,是我们迫切需求解决的问题。

这次分享主要包括以下几个方面:

1. 讲解公有云NFV领域的发展现状,各头部厂商当前的研发进展;

2. 介绍移动云新一代云原生奔流NFV平台的实现架构和主要功能;

3. 介绍奔流NFV平台的技术亮点;

4. 奔流NFV平台未来的规划演进。

头部云厂商AWS在2017年发布了支持动态弹性伸缩的NFV平台HyperPlane,目前基于该平台的负载均衡、接口终端节点、中转网关、无服务器计算等业务产品已经在AWS上线,并实现了规模化商用。

AWS Hyperplane的平台的架构优势主要体现在以下几个方面:

1. 以Cell为最小单元,实现最小故障域,每个Cell有独立的控制面和数据面,单个Cell都可实现T级别的吞吐和上亿级的并发;

2. 每个Cell都具有通用的数据面和控制面,如图所示,第一层TOP层负责无状态转发,第二层Flow Master层负责记录网络连接,第三层 Decider层负责网元功能(如LB或者NAT的功能),通过分成结构实现每层的动态扩缩;

3. TOP层是无状态,故障后报文可以Hash到原来的Flow Master节点,保障了TOP层的高可用;Decider层和Flow Master层本身具备主备的高可用架构,从而保障了整个Cell节点的高可用;

4. HyperPlane 通过Shuffle Sharding 算法将单个用户的流量引流到某几个节点,同时尽量减少租户业务重叠的概率,从而保障用户业务之间互不影响。

阿里云在洛神3.0的架构中,构建了新一代云原生的CyberStar NFV平台,其最大特点是NFV平台不再直接部署在裸金属服务器或专用计算资源池内,而是基于云上通用虚拟实例ECS部署,实现分钟级弹性伸缩和按需随时购买。

相比于传统的NFV平台,洛神架构3.0的Cyberstar NFV平台具备以下几个优点:

1. 基于Cyberstar的网元,用户不再需要配置任何露营,可实现自动引流,实现面向应用的连接;

2. 基于ECS不上的网元,配合SDN的多活多租,实现了网元任意规格的分钟级弹性扩缩容,满足租户的突发业务需求;

3. Cyberstar 平台和齐天大数据智能分析系统对接,并推出NIS网络智能服务,实现网络的智能运维分析;

4. 屏蔽了底层硬件的差异,优化了交付效率,提升了资源利用率,进一步降低了投资成本。

通过云上虚拟ECS实例构建云网络的NFV网元,不是简单的改变部署形式就可以支持,这里关键的技术点是如何在虚拟网络里面提供虚拟网络功能。如何实现和其他租户地址空间的连接,如何能获取到不同租户信息,提供多租户共享和隔离的能力,这是新一代的云网络NFV平台要提供的能力。

阿里云CyberStar平台提出了ENI-bonding和ENI-trunking的概念,通过ENI-bonding,使用标准云原生网络对象,打通云上租户ECS和NFV网元的的网络连通性,使用ENI-trunking,不同用户的流量在转发至NFV网元,打上不同的VLAN TAG,标识不同的用户,实现租户隔离。CyberStar平台在提供云计算虚拟网络的同时,也开始基于云原生的能力提升NFV网元自身的能力,NFV网元可以使用不同规格的ECS,提供不同类型的网元,例如七层负载均衡计算能力的要求更高,可以选择计算型ECS,而四层负载均衡对转发吞吐的要求更高,可以选择网络型ECS。

从2009年至今,移动云的NFV发展已经经历三个阶段,正在向第四阶段新一代云网络NFV架构演进。

阶段一:多使用硬件设备,逻辑固化,新需求开发周期需要以年为单位,无法横向扩展,使用的厂商封闭系统,仅提供少量的配置接口,开放性不足。

阶段二:使用通用的x86服务器,不再受专用硬件限制,可以自行进行软件迭代,但是因为承载在物理机上,仍然需要进行一定的硬件适配,集群可横向扩展,系统开放性较高,根据业务,可自定义系统功能。

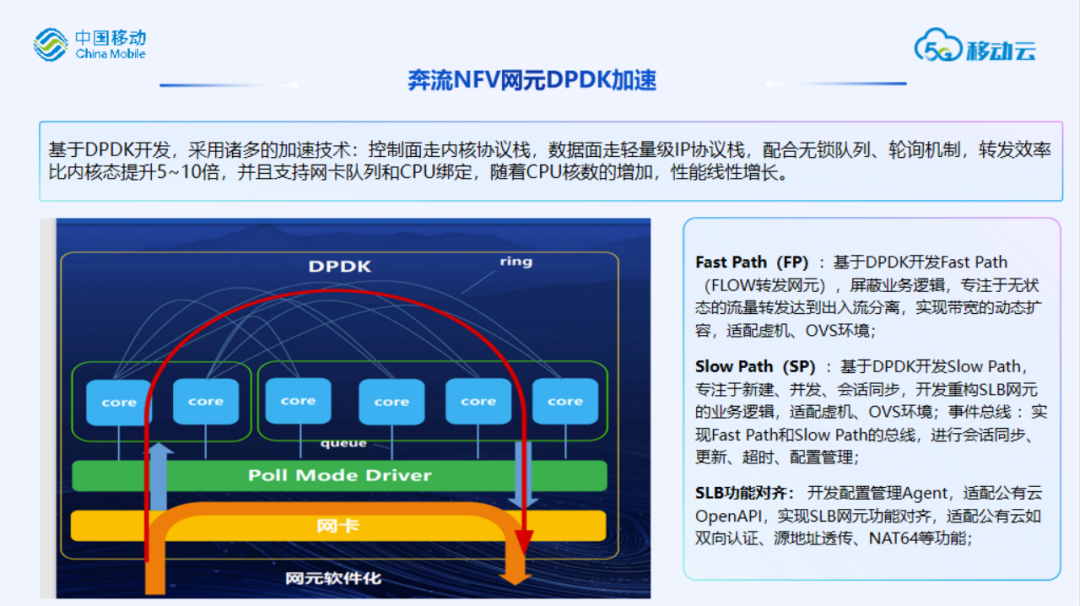

阶段三:转发逻辑是在Linux Kernel中实现,会存在明显的性能瓶颈,在使用高性能网络库DPDK实现NFV 1.0的转发逻辑后,其转发性能提升了10倍+。

阶段四:通用云主机,不再需要适配硬件,拥有极致的敏捷性,因为是通用云主机,其容量与云主机等同,对用户而言是海量资源,可以快速扩展,极高的开放性,第三方网元只要能运行在通用云主机中,即可以开放给云上其他租户使用。

移动云新一代云原生NFV平台整体架构参考阿里云Cyberstar平台,NFV平台配合SDN多活多租特性,基于通用云主机,实现配额管理、集群管理、资源决策、实例管理、配置下发等通用资源编排调度能力;加速平台通过通过DPDK 、P4等对OVS 、协议网关、虚拟网关等进行加速,形成标准化加速平台;通过DPDK加速的软件网元,通过重构适配NFV平台的通用加速平台能力和虚拟化能力,快速提升业务性能,实现动态弹缩能力,达到快速能力演进和上线的目标。

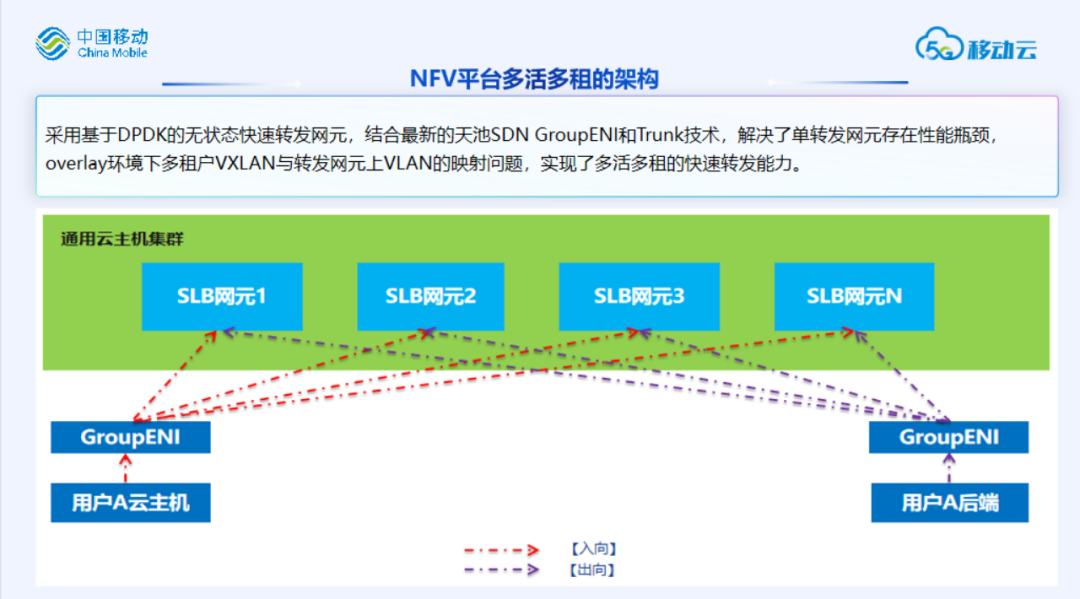

采用基于DPDK的无状态快速转发网元,结合最新的天池SDN GroupENI和Trunk技术,解决了单转发网元存在性能瓶颈,overlay环境下多租户VXLAN与转发网元上VLAN的映射问题,实现了多活多租的快速转发能力。使用ENI-Bonding支持多活,使用ENI-trunking支持多租,使用使用DPDK开发转发节点,多核转发,转发层会话从会话层查询获得,根据实际业务流量,实现转发层动态弹缩。

采用基于DPDK无状态的快速转发网元,当客户端请求第一次到达时,转发网元向会话节点查询会话信息,并缓存至本地;当第二次同一个五元组请求到达时,快速转发网元直接查询本地缓存的会话信息,直接将请求进行转发。结合DPDK的高性能转发套件,实现了高并发,高新建连接数,大带宽的转发性能。

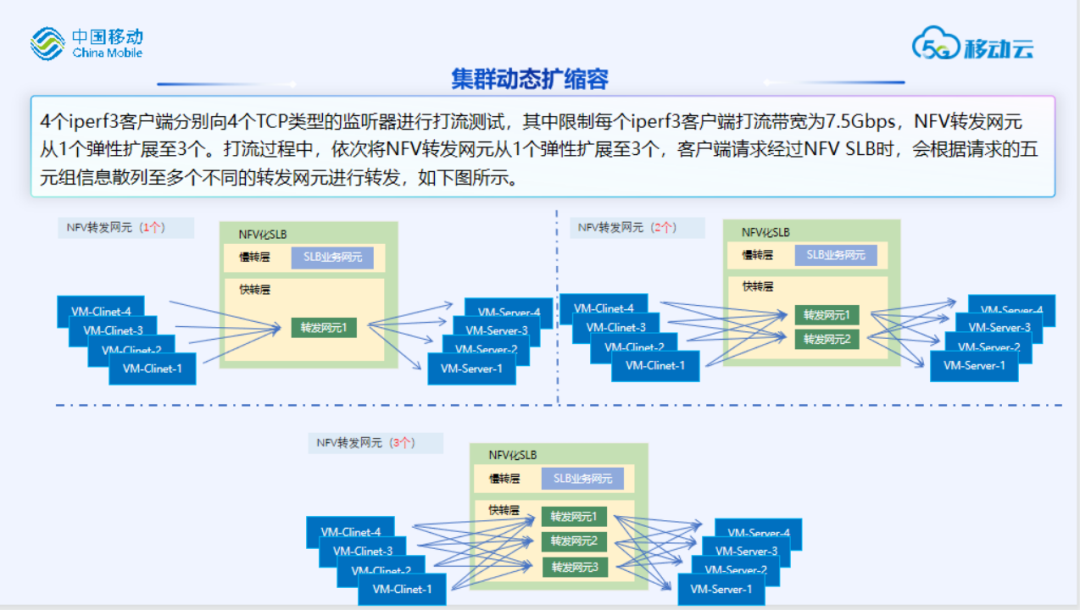

在打流过程中,依次将NFV转发网元从1个弹性扩展至3个,客户端请求经过NFV SLB时,会根据请求的五元组信息散列至多个不同的转发网元进行转发,如图所示。

4个iperf3客户端分别向4个TCP类型的监听器进行打流测试,其中限制每个iperf3客户端打流带宽为7.5Gbps,NFV转发网元从1个弹性扩展至3个,打流的结果见下页PPT。

由图表可以看出,NFV SLB实例的带宽吞吐,随着转发网元个数的线性扩展,从9.22Gbps动态线性扩展至27Gbps。在NFV转发网元缩容时,带宽吞吐会随着转发网元个数的减少而线性减少,此处不再赘述。

每个无状态的转发网元具备相同的带宽吞吐能力,通过弹性扩展转发网元的个数,达到了弹性扩展带宽吞吐的能力。相较于现网厂商的专有负载均衡设备的旗舰型实例,10G带宽吞吐的能力,NFV SLB实例可动态扩缩容的大带宽吞吐能力,更能满足现网客户峰谷流量模型的需求。

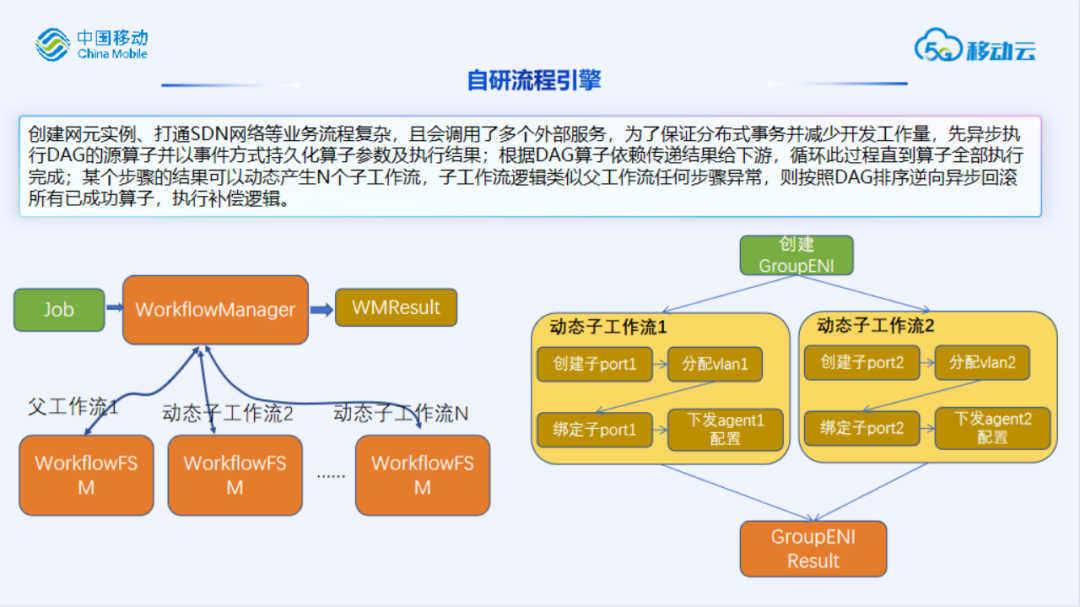

NFV平台创建网元、打通SDN等业务流程复杂,且会调用多个外部服务,为保证分布式事务并减少开发工作量,引入了流程引擎,主要工作流程如下:

1. 先异步执行DAG的源算子并以事件方式持久化算子参数及执行结果;

2. 根据DAG算子依赖传递结果给下游,循环此过程直到算子全部执行完成;

3. 某个步骤的结果可以动态产生N个子工作流,子工作流逻辑类似父工作流;

4. 任何步骤异常,则按照DAG排序逆向异步回滚所有已成功算子,执行补偿逻辑;

5. 如果工作流引擎本身宕机,则重启后根据持久化的事件恢复状态并继续执行或回滚。

当前NFV平台集群会话层采用的主备模式,会话能力受限于单节点的能力,未来演进可在SP集群之上新增会话层,各会话节点采用主备模式,支持会话能力扩展。

目前奔流NFV平台和自研天池SDN适配,取得了阶段性的进展:实现了SLB网元的接入,其性能指标新建连接数可达40w,最大并发连接数可达400w,带宽吞吐可动态扩缩容,该性能压测结果均超预期。后续会增加LCU计费、自动扩缩容、集群迁移容灾、沙盒机制、接口标准化、第三方网元接入等高阶能力,并且提供GWLB等平台等。

扫码可得活动回顾及专家PPT

这一期的TeaTalk· Online我们跟随刘老师,了解了移动云奔流NFV平台的奥妙所在,希望我们陪你们度过了一个充满想象力的夜晚。作为开发者社区系列活动的重要一环,未来TeaTalk· Online线上直播栏目将更加专注细分技术领域,进一步扩展知识广度、技术深度,加速拥抱开发者。

继续关注我们吧,我们下一期不见不散!

诚邀加入移动云开发者社区

共筑移动云生态!

扫码进入

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 习近平访欧留下许多外交佳话 4988630

- 2 汶川女护士:今天过节不敢说庆祝 4998885

- 3 女子因琐事刺死男友已被刑拘 4839023

- 4 何为“双向奔赴”的中匈关系 4768110

- 5 华语乐坛还有谁能来救救那英 4640811

- 6 水泥封尸案嫌疑人邻居发声 4551456

- 7 十年前的回旋镖落到那英身上 4466685

- 8 4S店忘贴车衣女子想退掉保时捷 4367776

- 9 旅美熊猫洋洋饿得啃墙皮?假的 4253211

- 10 丈夫伪造100万存单被妻子拿去银行 4119201

![尚娜 独自撑伞的日子 也一定要顺顺利利[航天员] ](https://imgs.knowsafe.com:8087/img/aideep/2023/9/25/de8ba0c028dbd12912ffc93b435322c7.jpg?w=250)

![37度的幼嫩希望你自由的活着,永远在看花的路上。[哈欠] ](https://imgs.knowsafe.com:8087/img/aideep/2023/8/30/28e0f85f4cf0195b807c1720bf72f8f8.jpg?w=250)

AI100

AI100