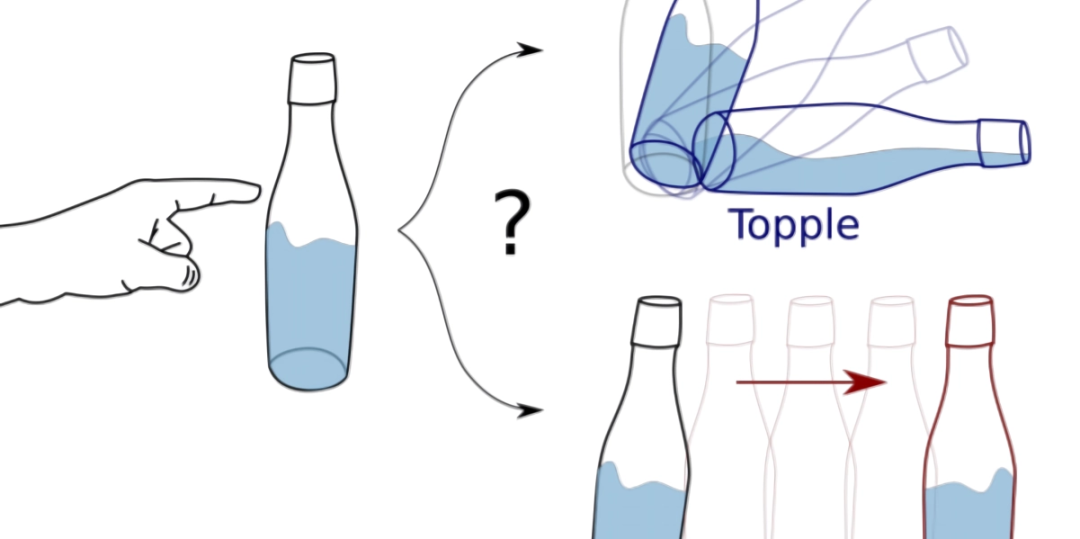

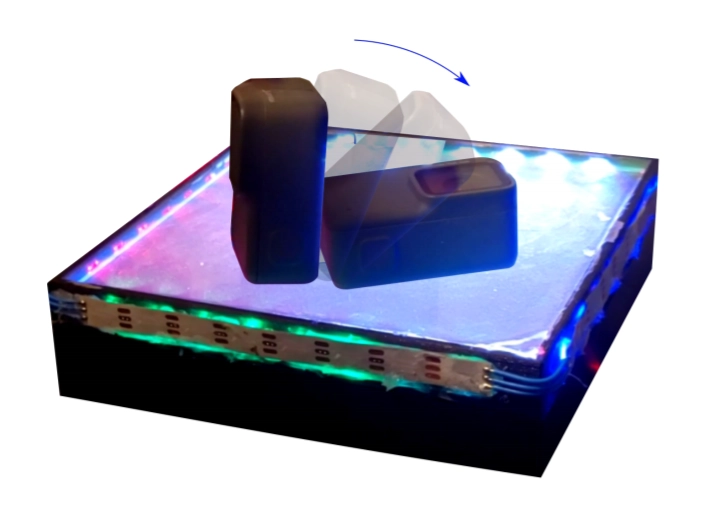

AI框架可根据图像和触觉数据预测对象的运动

https://venturebeat.com/2021/01/18/researchers-develop-ai-framework-that-predicts-object-motion-from-image-and-tactile-data/

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

赞助链接

排名

热点

搜索指数

- 1 钓鱼台漫步和意悠长 4996455

- 2 以色列导弹击中伊朗境内目标 4902587

- 3 伊朗叙利亚伊拉克传出爆炸声 4899412

- 4 4.0版消博会 外资看中三个“新” 4776950

- 5 抗战烈士墓发现年轻女子照片 4674882

- 6 周深在联合国总部献唱 4525860

- 7 肯尼亚国防军司令坠机身亡 4425831

- 8 长沙楼市“以旧换新”政策落地 4392685

- 9 养老保险断缴即清零?不实 4277298

- 10 美军在菲部署中程导弹 外交部回应 4126262

大数据文摘

大数据文摘