I/O 亲历:两年不见,谷歌的 AI 又把我们吓了一跳

在经历了一整年的新冠疫情之后,时隔两年谷歌 I/O 开发者大会终于和大家再度相逢。

今天,我们再来深入探讨一下,从这届 I/O 大会上我们看到谷歌在 AI 方面的更多重要突破和新动作。

Transformer 的无限边界

2014年,被称为“机器学习三剑客”之一的 Yoshua Bengio 教授团队提出了注意力 (attention) 机制。基于这一机制,谷歌团队在2017年推出了深度学习模型 Transformer。

谷歌推出深度学习模型 Transformer,图来源于网络

和卷积/循环神经网络 (CNN, RNN) 等“传统”的神经网络模型不同,Transfromer 的网络结构主要构成部分都是注意力机制,解决了传统模型处理自然语言工作时,所采用的顺序计算模式带来的种种问题和限制。

不仅谷歌2019年基于 Transformer 技术开发的 BERT 算法在自然语言处理各项任务中的效能有了巨大提升,这项技术也已经被字节、美团、Facebook 等中美顶级公司广泛采用,证明了它的巨大潜力。

这一届 I/O 大会上,谷歌又宣布了在自然语言处理和知识处理等方向上的全新突破:LaMDA 和 MUM。

简单来说,LaMDA 是一个专门为对话而优化的自然语言处理生成模型。它是一个底层技术,不过为了展示它的能力,谷歌选择用聊天机器人的方式来呈现:假设用户希望了解冥王星的更多信息,LaMDA 则可以扮演冥王星和用户展开一场自然亲切、寓教于乐的对话。

自然语言处理生成模型:LaMDA,图来源于网络

而 MUM 是一个超级强大的多模态学习模型,在解答复杂问题上的能力远超前辈技术。过去我们使用搜索引擎,经常需要修改自己的问题好让计算机理解;现在有了 MUM,我们可以直接向搜索引擎提问,不论问句的句式有多复杂,信息量有多大,MUM 都能够实现准确的上下文理解,并且从75种语言的网络资料中实时提取、翻译、组织和呈现答案。

谷歌 AI 部门产品主管克里斯汀•罗布森(Christine Robson)接受视频采访时表示,LaMDA 和 MUM 的底层都是 Transformer,本小节一开始提到的自然语言处理重要架构。

几年前 Transformer 和 BERT 发布的时候,就被认为是机器学习技术的重要突破。而今年谷歌在 I/O 上预览的这两个新模型,再次证明了 Transformer 尚有无限大的发展空间。

以 MUM 为例,据罗布森透露,它和2018年谷歌发布,被称为自然语言处理“大杀器”的 BERT 算法相比,性能有了足足1000倍的提升,堪称 Transformer 技术方向的又一重大突破。

MUM 不仅能够理解,还可以生成语言。谷歌同时采用75种语言,面向对话理解、对话生成、提炼总结、翻译等多种不同的自然语言处理任务对 MUM 进行了训练。这样训练出来的 MUM,在搜集、处理知识和生成信息的能力上,深度前所未有。

更令人兴奋的是,MUM 还是一个多模态模型 (multimodal model),除了文字之外现在还可以从图片中提取信息,未来也会引入视频、音频等更多模态——进一步扩展了 Transformer 的实力边界。

有趣的是,今年三月谷歌研究员曾经发过一篇论文,用做了各种微调的 Transformer 架构进行跨应用方向的试验,发现效果并不算很好。时隔两个月,通过 LaMDA 和 MUM,谷歌自己在 I/O 上就给其它研究人员和开发者们做了一个“怎样正确使用 Transformer”的优秀示范。

“最让我个人感到兴奋的,是看到 Transformer 技术宏大的发展曲线,” 罗布森表示。她说,2017年发布并开源 Transformer 的时候,就已经预料到它会有很大的潜力;然后有了 BERT,整合到搜索当中显著提高了搜索结果,“今天看到 MUM 和 LaMDA 的表现,我相信 Transformer 还有很长很令人兴奋的路要走。”

为什么 Transformer 对于谷歌来说如此重要?

“我在 AI 领域从业很多年了。我的感受是,实现真正的自然语言理解一直都是一个难以企及的目标,我们的每一次突破,其实都离那个目标更近了一步,但从未真正达到,”罗布森这样说道。

“语言是人类实现沟通的最自然的方式,所以让机器实现真正的自然语言理解是我们一直追寻的目标。现在我们看到 Transformer 的潜力如此巨大,让我们从未离这个目标如此之近。”

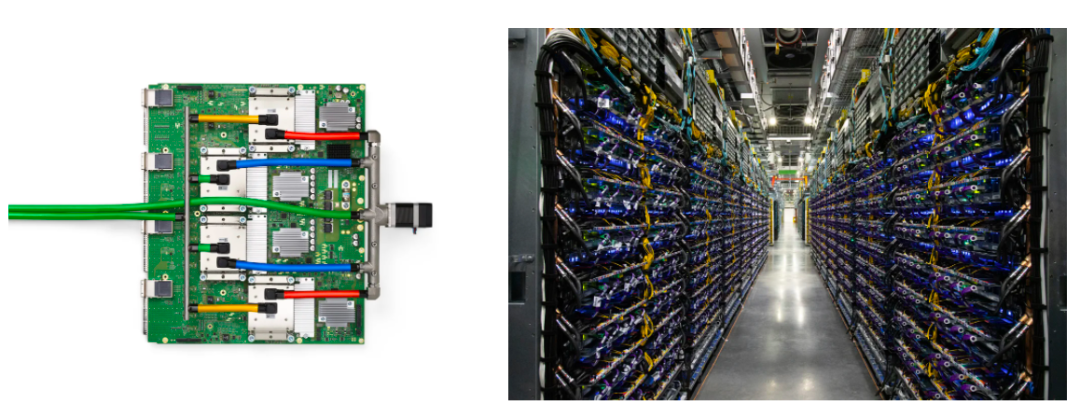

当然,并不是所有人都能享受到 MUM 和 LaMDA 所依赖的计算环境,比如谷歌的 TPU 芯片和 TPU Pod 云计算模块。

TPU 计算设备在今年 I/O 大会上也正式宣布升级到 v4,单芯片(下图左包含4颗芯片)的计算速度是 v3 的两倍,而 TPU v4 Pod(下图右)搭载4,096颗 TPU v4 核心,总计浮点算力高达 1 exaflops(每秒一百亿亿次浮点运算)。罗布森透露,谷歌最近在 Transformer 相关技术上实现突破,TPU 优越的计算环境居功甚伟。

虽然现在谷歌把这两项技术通过聊天机器人和搜索引擎的方式呈现,实际上 LaMDA 和 MUM 都还是非常早期的研究项目,距离商用化还很远,甚至目前连论文都还没有。谷歌还有很多这样的,在内部称为“moonshot”的项目。

以 MUM 为例,谷歌在官网上表示,将该技术应用到搜索当中还存在一些不小的,社会责任方面的挑战。和 BERT 一样,MUM 也会经历一个较为漫长、十分严格的审核流程,谷歌希望在这样的流程中能够发现这些前沿技术可能存在的社会责任问题,比如偏见、耗能等等。

这意味着我们不会在近期看到 MUM、LaMDA 等技术,被整合到搜索、Google Assistant 以及其它谷歌产品和服务当中。当然,和我们一样,谷歌自己也很期待它们能够真正派上用场的那天。

生活有用,娱乐有趣

虽然诺基亚早已淡出了科技圈的第一梯队,“科技以人为本”的理念仍贯彻于各大公司,这些公司当中就有谷歌。

目前,谷歌一些先进的 AI 研究成果,和核心业务、重要产品服务的整合度不高。当然正如刚才提到,大公司有更复杂的运作机制,面临着更多社会责任方面的挑战。以及最近吴恩达也表示过,所有的 AI,从”概念证明“到”投入商用“都有很长的路要走。

而从本届 I/O 大会上,我们也看到了谷歌正在加大 AI 技术投入到全线产品中的努力。

地图:

谷歌在大会上表示,仅今年,AI 技术就已经帮助 Google Maps 了实现超过100项功能更新。而在不远的未来,还有更多新功能和体验优化正在赶来的路上。

在导航方面,地图团队发现最快的导航路径并不一定是最好的,很多时候这些最快路径反而车流量更大、交通情况更复杂,一个最关键的问题,就是司机经常遇到“突然刹车”的情况,而数据显示突然刹车和交通事故发生的关联度更高。

所以,谷歌将在未来的版本更新中加入一种新的导航逻辑:推荐交通情况更“均衡”和流畅,突然刹车的可能性更小的导航路径,引入道路的车道数、路径笔直程度、信号灯数量、行人的人流等等。通过新的导航逻辑,谷歌预计每年能够帮助用户减少一亿次突然刹车的情况,“让你从 A 到 B 更快,同时也更安全。”

借助机器学习计算机视觉的力量,谷歌现在还对全球大量的卫星图片进行了分析,在地图上标注人行横道的位置,帮助使用地图的行人用户也能更安全地过马路。该功能即将支持全球超过50个城市:

谷歌地图功能,图来源于网络

疫情期间,很多用户出门购物、用餐的时候,都会更多留意谷歌地图上目的地忙碌程度的功能,错峰出行。好消息是,同样利用机器学习挖掘数据,现在谷歌可以把一个更大区域的忙碌程度也呈现给用户:

谷歌地图,图来源于 Lens

谷歌的云相册产品 Photos 现在已经存储了超过4万亿张照片,但是团队也发现一个大部分人应该清楚,但平时很少意识到的问题:我们的大部分照片,最后都只是存了起来没有再翻看过(小吐槽:为了存照片多花钱买大容量手机,真的值得吗?)——但这些照片,对用户并非没有价值。

如何挖掘价值,Google Photos 团队开动脑筋,而他们做出了这样一个功能:从海量的照片当中抓取微妙的相同细节,把内容看起来相似的,或者包含了相同人物、物品的照片,集合到一个 memory(自动生成的相片册)里。

这些照片存放在虚拟世界的角落积灰,并没有多大的意义,但如果被集合起来,其实讲述了一个又一个美好的,可能早已被我们遗忘的故事。比如,你可能会惊讶地发现,那只从大学时候爸妈送给你,早就背烂了扔掉的黄色书包,其实曾经陪伴你游历了天南海北,

谷歌相册自动生成的相册,图来源于网络

另一个新功能叫做 Cinematic moments:Google Photos 现在可以借助神经网络的力量去分析几张相似照片之间的关联,猜测并且补完缺失的细节,生成一个小短片保存下来。这个功能和 iOS Live Photos 等类似功能不同之处在于,它拍的仍然是照片,而不是视频。几张照片之间的时间跨度可以更大。

谷歌相册自动生成的相册,图来源于网络

除了用 AI 为用户提供更多帮助,在”用 AI 带来更多娱乐“这件事上,谷歌也没有落下……

今年 I/O 主旨演讲开场之前,谷歌还是照例组织了暖场音乐会。每年的这个环节都带有些许各式各样的科技成分。而今年的现场表演,看起来有两位嘉宾,是加州本地的实验乐队 tUnE-yArDs。

但实际上除了她们俩人之外,还有9位嘉宾!

看到下面图中箭头所指的地方了吗?它们就是今年暖场音乐会的特邀嘉宾 :Blob Opera,由9个 blob 组成(也就是原生 Android 用户熟悉的 emoji 形象的那个 blob,只不过这次这次出镜的形象特别高清……)

Blob Opera与tUnE-yArDs同台演绎,图来源于网络

Blob Opera 是谷歌少为人知的艺术和文化发展部门,旗下的一个实验性项目,由数字艺术家大卫·李(David Li) 主导开发,去年首次面世的时候就曾经引发不小的轰动,甚至还展开了一场”全球巡演“——当然是虚拟的。在项目网站上,玩家可以自己创建一个”合唱团“,定制每一位”歌手“的音调,或者让它们演唱已经保存好的曲目。

I/O 2021 的暖场音乐会,也是 Blob Opera 首次和真人歌手同台合作。

Blob Opera 的背后是两个基于卷积神经网络的模型,一个负责唱,另一个负责安排和弦。当然,训练过程中也借助了人类歌手提供的数据。训练过后,计算机不仅学会了如何将音调和口型结合起来,还能努力配合真人歌手演出,完成对唱或和声,尽管效果十分滑稽……

Blob Opera,图来源于网络

参与了前期准备和彩排工作的谷歌员工表示,Blob Opera 的歌声”太洗脑“了。在现场,Blob 们模仿真人歌手”鹦鹉学舌“的样子也超级搞笑……

当搜索公司遇到医疗

AI+医疗是今年谷歌想要在 I/O 大会上着重展示的另一个重要方向。

实际上,谷歌做医疗已经有相当长一段时间了,在2016、17年就提出过用计算机视觉做糖尿病早期检测;之前谷歌拆分成立 Alphabet 的时候,还专门组建了一家医疗科技公司 Verily。但总的来说,谷歌医疗方面的商业化进展并不是很快(当然这也许不是一件坏事。)

今年 I/O 上,谷歌介绍了 AI 医疗团队开发的 Derm Assist 项目。这是一个由机器学习计算机视觉算法驱动的工具,能够仅用普通手机或者网络摄像头的画面,准确地判断用户皮肤可能出现的病变情况,分析病情,提供准确的信息。

Derm Assist 项目,图来源于网络

这个项目,最初来自于谷歌搜索引擎每年都会收到数十亿次关于皮肤、指甲和头发问题的查询和提问。全球预计有19亿人患有不同程度的皮肤病,但由于皮肤病多种多样,在搜索引擎上很难描述清楚,用户也就不容易得到足够准确和有针对性的答案。与此同时,可信赖的皮肤病专家也存在全球短缺,只能由全科医生顶替,而全科医生的误诊率浮动程度很大,总体的诊断准确度比专科医生差很多。

结果很多患者因此无法及时、准确了解到自己的病情发展,错失最佳治疗时间

谷歌AI医学专家佩吉·贝(Peggy Bui)博士接受采访时表示,自打项目伊始,她们就在思考,在训练机器学习模型的时候应该聚焦什么方向,是用超高清的、显微镜级别的画面来辅助医生做出诊断,还是用任何摄像头都可以拍的普通照片也行,从而最终为更多的普通用户提供一个更好用的皮肤病预测工具。团队最后选择了后者。

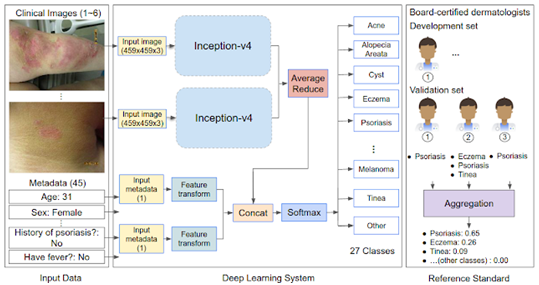

谷歌在2019年开始训练一个深度学习系统,采用 Inception-v4 神经网络架构,模仿临床医生的思维方式,整合拍摄的图像和年龄、性别等其它元数据进行处理。在实际使用中,这个系统可以根据皮肤症状排列出可能的皮肤病(范围达到26种),从而帮助患者进行快速分诊、诊断和治疗。

Inception-v4深度学习系统,图来源于网络

由于在设计和训练阶段有针对性地引入了多元化的数据集,Derm Assist的诊断准确性不受肤色的印象,对于深色皮肤的人士(他们通常比浅肤色者更难接触到高质量的医疗资源)是个好消息。Derm Assist 的 top-1(最可能患上的疾病)预测准确率为71%,top-3 准确率高达90-93%,甚至高于皮肤科医生 75%。

Derm Assist 将采用 PWA 的形式,也即通常理解的网页应用,可以在任何手机或桌面浏览器上运行,无需专门下载安装。它的网址是:health.google.com/dermatology

目前这项技术在美国属于一级医疗器械(最低级)的范畴,但尚未获得 FDA 认证。Bui 博士透露,预计今年年 Derm Assist 可以在欧盟国家开始使用。这项服务只扮演基本的初筛工作,只对来源数据进行分析并提供结果和皮肤病专家验证过的可信资料,不会推荐用户去哪里就诊。

更重要的是,用户上传的数据也会单独存放处理,和“大”谷歌的数据是完全独立的,不会用于推荐广告。

从五六年前用视网膜眼底扫描辅助早期糖尿病患者筛查,到今天,谷歌 AI 医疗技术研究部门已经拓展出了至少7个项目,针对糖尿病、老年性黄斑变性、贫血、心血管疾病、皮肤病、肺癌、乳腺癌、前列腺癌等多种疾病。

很多项目,在多年之后仍然没什么特别之的夸耀的进展。比如2017年的糖尿病项目,当时说会在印度尝试铺开,但截至目前也没有推广进展可分享,唯一公开的进展也只是说会尝试进入泰国。其它的项目,统一的说辞基本上就是“还处在开发测试阶段”。这样的情况给人一种印象,就是谷歌做 AI 医疗雷声大雨点小。

但是换一种方式思考,或许给谷歌更多的时间也能让它思考的更清楚。这是一家搜索起家,现在全面投入 AI 的公司,而这两个话题在数据操守、安全和社会责任方面的争议性都不低。这样的一家公司去做 AI 医疗,稳妥也许不是件坏事。

以上这些只是今年得到 AI 方面新内容的一小部分。因为篇幅限制,还有很多没有提及。

比如谷歌全新的“量子AI计算营”(Quantum AI campus),集合了实验室、芯片工厂,以及谷歌的第一座量子数据中心:

谷歌全新的“量子AI计算营”,图来源于网络

比如 Google Workplace(原 GSuite)三件套的许多新功能。

再比谷歌在驱动搜索引擎的知识图谱 (knowledge graph) 基础上开发的购物图谱:用索引知识和理解知识之间关联的方式,谷歌现在也在尝试为全世界的商品资料、购物网站、库存数据、评价信息之间建立关联,帮助用户更好地完成购物(顺便让更多的购物流量和数据留在谷歌平台上……)

I/O,希望明年还能线下再见!

关注硅星人,你就能了解硅谷最新的科技进展和湾区的大事小情,变身最in技术潮人

特斯拉暂停比特币付款方式;SpaceX公布星际飞船首个轨道飞行计划|前沿科技周报

过气网红Clubhouse:下载量暴跌90%,收购不成被山寨,想注销没门儿

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 中法元首相会都江堰 7904502

- 2 中方不接受日方所谓交涉 已当场驳回 7809460

- 3 大闸蟹为何会在欧美泛滥成灾 7714093

- 4 国际机构看中国经济 关键词亮了 7615873

- 5 家长称婴儿被褥印不雅英文单词 7520863

- 6 日方军机滋扰擅闯或被视为训练靶标 7428277

- 7 罪犯被判死缓破口大骂被害人一家 7333668

- 8 国乒8比1击败日本队 11战全胜夺冠 7232306

- 9 长沙一男子要取现20万 银行紧急报警 7141335

- 10 千吨级“巨无霸”就位 7043728

硅谷洞察

硅谷洞察