2021 “OPPO安全AI挑战赛”初赛正式启动,聚焦人脸识别攻防

2021年7月12日,由OPPO发起,OPPO安全主办的“OPPO安全AI挑战赛”正式开放提交。本次比赛要求选手通过创新的方法对机器学习模型进行攻击,总奖金60万元。

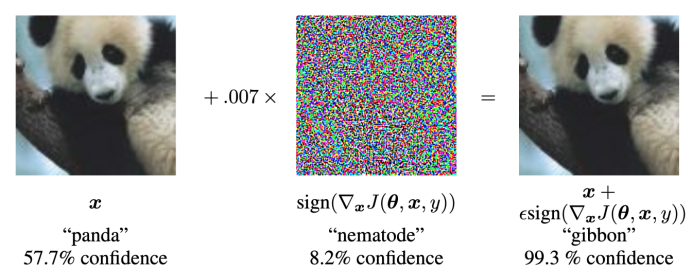

过去10年,深度学习已经在很多不同的领域获得了令人瞩目的成功,也已经深入到各行各业和我们的生活。不过,科学界和工业界随后也发现,深度学习模型展现出了令人不安的脆弱性。例如,在图片分类任务中,只需要给一张图片加一点人类难以注意的噪点,就能让深度学习模型完全误判图片的内容。一个著名的例子是来自Ian J. Goodfellow等人在2015年ICLR上发表的论文,在向一张熊猫的照片加入少许噪音后,模型会错误地将其判别为长臂猿,尽管人类仍然能轻松地看出修改后的图片仍然是一只熊猫。

图1:熊猫图片加噪声后被图像分类模型识别为长臂猿

如果说把熊猫认成长臂猿还没有什么直接的负面影响的话,深入生活的智能应用受到攻击,就可能会造成糟糕甚至灾难性的后果。例如,目前的无人驾驶系统有时在识别Stop Sign这样的重要交通标记时,会因微小的变化出现严重的误判,这就有可能会对交通安全造成严重的后果。此外,还有研究团队发现,在佩戴了一副含有对抗样本图片的眼镜后,攻击者可以破解很多手机的人脸识别解锁功能。

因此,提升深度学习模型的稳定性,能让模型抵御外界天然和人为的攻击,成为目前人工智能领域学术界和产业界都极为关注的问题。

由OPPO发起,OPPO安全主办的“OPPO安全AI挑战赛”,主要聚焦人脸识别场景中的对抗攻击。为了模拟真实的人脸识别场景并增加比赛的难度,组织者在后台使用了一组已经添加了防御措施的识别模型,要求参赛选手在不知道这些后台模型具体细节的前提下,对它们进行黑盒攻击。

数据集与任务

本次比赛主要使用人脸识别数据集,具体的图片来自公开数据集CASIA-FaceV5和CelebA中的人脸图片。每个人都有2-5张不同图片,并被保存在一个文件夹中(如./images/0/,./images/1/…)。

选手需要修改这些图片,并保留原始图片尺寸和数据集目录结构。同时,对图片的修改必须足够微小。关于扰动的添加对于图像质量的影响,比赛组织者采用添加了扰动Lp范数和Full Reference-IQA(FR-IQA)来进行评价,其中FR-IQA部分将采用MS-SSIM图像结构相似性指标来进行量化。除了自动判断外,在线下决赛环节,组织者还会对对抗样本的肉眼视觉差异进行更加严格的评判,即对抗样本和原始样本的视觉差异越小越好。

在把数据集提交到系统后,后台的防御模型会对上传数据集进行预测。攻击数据集要尽量让防御模型产生错误的结果。当攻击不成功时,得分为0,当攻击成功时,得分由扰动添加前后的图像差异大小来衡量,对原图的影响越小得分越高。最终得分由扰动大小和判断原图片和修改后图片的图像质量评分(multi-scale structural similarity)共同决定。

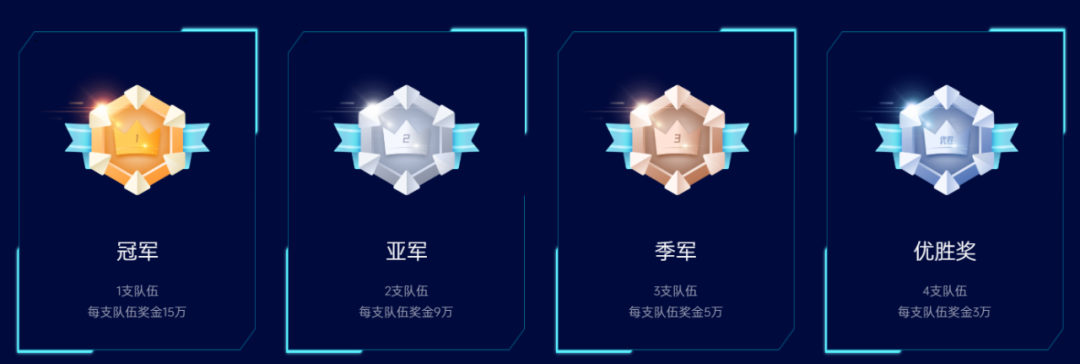

总奖金60万元

冠军:15万元

亚军(2支队伍):每支队伍9万元

季军(3支队伍):每支队伍5万元

优胜奖(4支队伍):每支队伍3万元。

此外,获奖团队还将获得组委会颁发的证书、OPPO校招绿色直通车和更多神秘礼物。

相关技术

现有的对抗样本从攻击类型上来说可以分为白盒攻击和黑盒攻击两类。白盒攻击可以允许攻击者了解被攻击模型的参数等细节,而在黑盒攻击过程中,攻击者无法知道模型的内部参数和其他细节,只能通过查询模型的输入和输出对模型的弱点进行推测。所以,在日常应用中,黑盒攻击更为接近实际情况。

本次比赛要求参赛选手使用黑盒攻击技术,对提前在比赛后台准备好的模型进行攻击。目前,对黑盒算法的研究主要分为基于神经网络迁移性的黑盒攻击(transfer-based black box attack),基于获得分数的黑盒攻击(score-based black box attack),以及基于决策边界的黑盒攻击(decision-based black box attack)。其中,基于决策边界的黑盒攻击不需要模型输出的置信度,因而应用范围最广,也适用于本次比赛的赛题。

基于决策边界的黑盒攻击最早发表在ICLR 2018年的论文《Decision-based adversarial attacks: Reliable attacks against black-box machine learning models》,作者从一个含有较大扰动的图像开始实验,然后逐渐减小扰动,直到找到模型的决策边界。与正常图像最接近的对抗样本就存在于决策边界附近。论文作者还以此构建了一个专门用于攻击人工智能模型的库Foolbox。代码链接(PyTorch和TensorFlow两种语言):https://github.com/bethgelab/foolbox。

不过,黑盒攻击方面的研究目前还面对很多问题。例如,很多攻击方法依赖于大量查询被攻击的模型,这种要求在实践中往往并不实际。在本次比赛中,因为每支队伍提交次数受到限制,也不可能无限制的查询模型。目前,在这方面已经出现了一些探索,例如,CVPR 2021的论文《Simulating Unknown Target Models for Query-Efficient Black-box Attacks》提出可以结合元学习的方法,训练一个“模拟器”,用于模拟任何未知模型的输出。这样,就能把大量查询转移到模拟器上,有效降低被攻击模型的查询复杂度。(代码地址:https://github.com/machanic/SimulatorAttack。)

结尾

可以预见的是,针对人脸识别安全的技术研发和社会治理工作将是一个长期的过程。竞赛主办方亦希望,此次“OPPO安全AI挑战赛”不仅是各路参赛者的实力大比拼,还能帮助各队伍增进对人脸识别黑盒攻击技术的认识,进而为安全AI事业提供新的发展契机。

点击“阅读原文”进入官网了解详情吧~

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 习近平同马克龙交流互动的经典瞬间 7904804

- 2 黑龙江水库冰面下现13匹冰冻马 7808684

- 3 微信表情包戒烟再度翻红 7712040

- 4 2025你的消费习惯“更新”了吗 7618003

- 5 三星堆与秦始皇帝陵竟有联系 7523763

- 6 为啥今年流感如此厉害 7426078

- 7 劲酒如何成了年轻女性的神仙水 7327513

- 8 一身塑料过冬?聚酯纤维真是塑料瓶吗 7231884

- 9 日本友人捐侵华日军家信内容残忍 7142909

- 10 中疾控流感防治七问七答 7040038

OPPO安全应急响应中心

OPPO安全应急响应中心