网红模型作者是调包侠?Reddit 小哥发布手势绘画模型,获超2300个赞

新智元报道

新智元报道

来源:Reddit

编辑:LRS

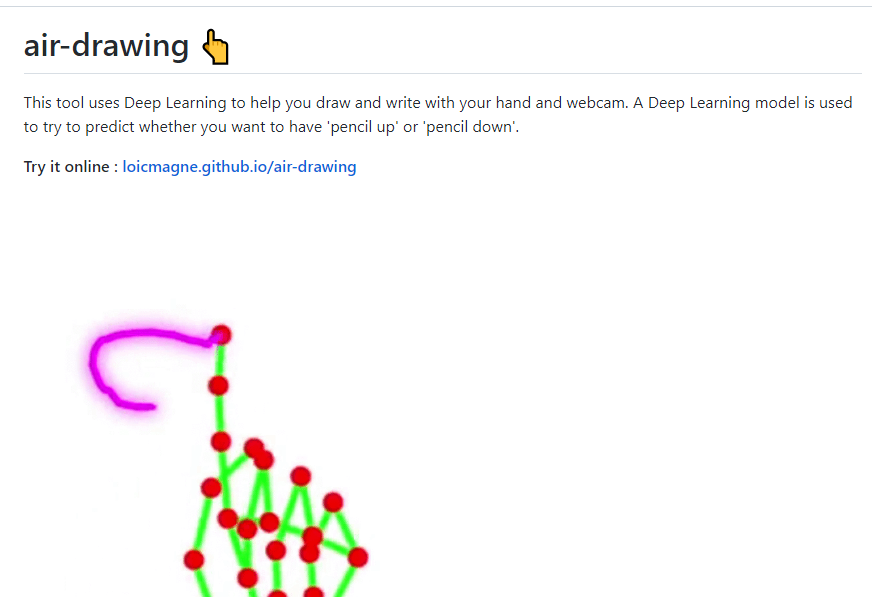

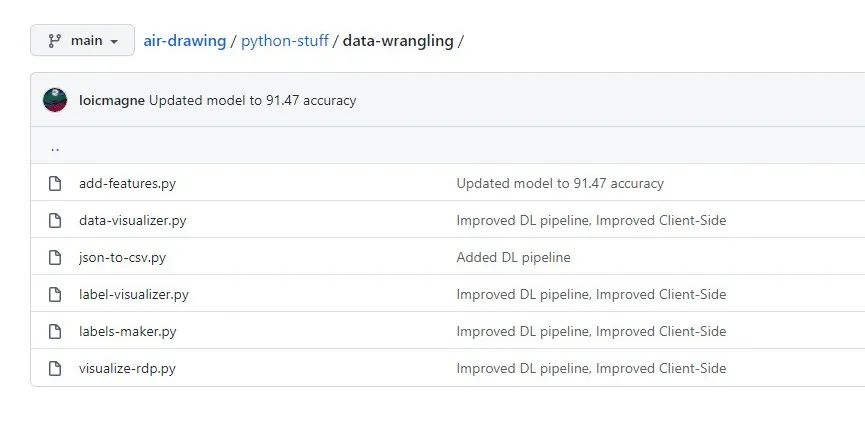

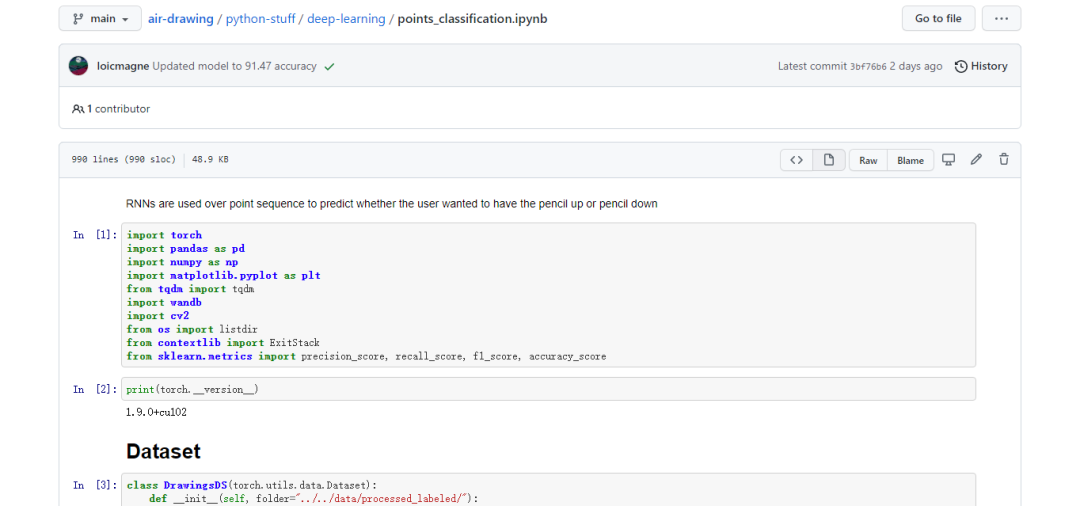

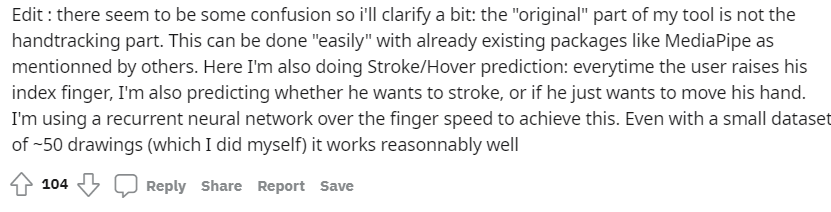

【新智元导读】最近Reddit上一个贴爆了,获得超两千三百个点赞!一个小哥发布了自己做的深度学习模型,可以隔空写字,并把无关的笔划给去除掉。有网友质疑他只是调包,而作者认为自己做了很多工作,由此引发了激烈的讨论!

参考资料:

https://www.reddit.com/r/MachineLearning/comments/pmqtj9/p_using_deep_learning_to_draw_and_write_with_your/

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

赞助链接

排名

热点

搜索指数

- 1 中法元首相会都江堰 7904393

- 2 中方不接受日方所谓交涉 已当场驳回 7808803

- 3 大闸蟹为何会在欧美泛滥成灾 7712075

- 4 国际机构看中国经济 关键词亮了 7618581

- 5 药酒里泡了十余年的海马竟是塑料 7521780

- 6 日方军机滋扰擅闯或被视为训练靶标 7428891

- 7 日军机滋扰辽宁舰训练 中方严正交涉 7333896

- 8 国乒8比1击败日本队 11战全胜夺冠 7233717

- 9 罪犯被判死缓破口大骂被害人一家 7139246

- 10 千吨级“巨无霸”就位 7040441

![徐珺大哥(更新啦[笑而不语] 望秒懂 ](https://imgs.knowsafe.com:8087/img/aideep/2022/12/11/b009ee3c897d0f2ad70a31a9ed44aa00.jpg?w=250)

新智元

新智元