在近日举行的 CVPR 2020 大会上,最佳论文、最佳学生论文等奖项悉数公布。加拿大西蒙弗雷泽大学陈之钦(Zhiqin Chen )等人的「BSP-Net」相关研究获得了最佳学生论文奖,他们的论文题目是《BSP-Net: Generating Compact Meshes via Binary Space Partitioning》。在最新一期的机器之心 CVPR 2020 线上论文分享中,西蒙弗雷泽大学 (SFU) 博士一年级学生陈之钦以第一作者的身份向我们分享了这篇最佳学生论文。

在这项研究中,西蒙弗雷泽大学和谷歌研究院的三位研究者提出了一种无监督方法,能够通过 convex decomposition 生成紧凑的结构化多边形网格。

多边形网格在数字 3D 领域无处不在,但它们在深度学习革命中仅扮演了配角。在学习形状生成模型这一方向上,领先方法要依赖于隐函数,并且只有经过昂贵的 iso-surfacing 处理过程才能生成网格。为了克服这些困难,该研究在 Binary Space Partitioning(BSP,计算机图形学中的经典空间数据结构)的启发下探讨了促进 3D 学习的方法。

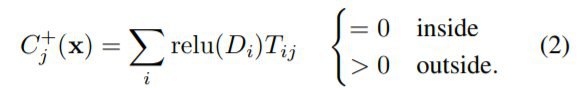

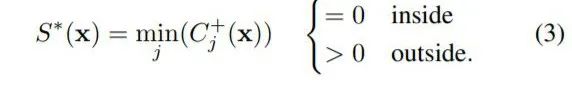

BSP 的核心是对空间进行递归细分以获得 convex set。利用这一属性,研究者设计了 BSP-Net,一个通过 convex decomposition 来学习 3D 形状表征的网络。重要的是,BSPNet 是无监督的,因为训练过程中不需要 convex shape decomposition。该网络经过训练,利用一组 convex 来重建一个形状,这些 convex 来自构建在一组平面上的 BSPtree。由 BSPNet 推断出的 convex 可被轻松提取以形成多边形网格,而无需进行 iso-surfacing 处理。生成的网格是紧凑的(即 low-poly),非常适合表示尖锐的几何形状。此外,它们一定是水密的网格,并且可以轻松地被参数化。该研究还表明,BSP-Net 的重构质量可以媲美 SOTA 方法,且它使用的 primitive 要少得多。该研究试图找到一种既能训练又可解释的几何图形深度表征。研究者们通过设计一种能提供可微分 BSP-tree 表征的网络架构来完成这个任务。由于这种表征通过隐函数编码几何图形,所以它们很容易训练。此外,由于这些表征的输出是 convex polytope 的集合,所以它们是可解释的。研究者提出了 BSP-Net。该网络学习一个隐式场:给定 n 个点的坐标和一个形状特征向量作为输入,网络输出一些能够指示这些点是在形状内部还是外部的值。这个隐函数的构造如图 2 所示,由三个步骤组成:1)平面方程的集合意味着空间的 p 个二叉分割的集合,参见图 2(上);2)一个算子 T_{p×c}将这些分割结果分组,以创建一个包含 c 个 convex shape primitive/part 的集合;3)最后,合并这些 part 集合以生成输出形状的隐式场。

1)超平面提取。给定一个特征向量 f,应用一个多层感知机 获取平面参数 P_{px4},其中 p 是平面的数量,即

获取平面参数 P_{px4},其中 p 是平面的数量,即 。

。

对于任意点? ,乘积

,乘积 ?是该点到每个平面的符号距离的向量。如果点 X 在内部,则第 i 个距离为负值,反之为正值。2)超平面分组。为了将超平面分为若干组几何 primitive,研究者利用了二进制矩阵 T_{p×c}。通过一个最大池化操作,他们聚合了输入平面,以形成一组 c 个 convex primitive 组成的集合。

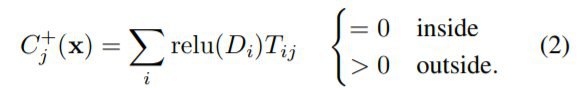

?是该点到每个平面的符号距离的向量。如果点 X 在内部,则第 i 个距离为负值,反之为正值。2)超平面分组。为了将超平面分为若干组几何 primitive,研究者利用了二进制矩阵 T_{p×c}。通过一个最大池化操作,他们聚合了输入平面,以形成一组 c 个 convex primitive 组成的集合。

注意,在训练期间,梯度只能通过一个最大(max)的平面。因此,为了简化训练,研究者利用了一个用求和代替 max 的版本。

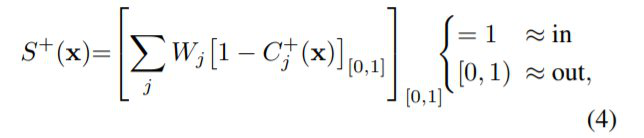

3)形状组装。该层通过最小池化对 convex 进行分组,以创建一个可能非凸的输出形状:

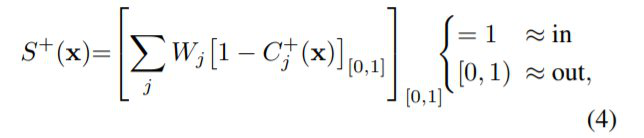

注意,此处用 C^+ 是有目的的。之所以避免使用 C^*,是因为在 TensorFlow 1 中的算子实现内存不够高效。为了促进学习,研究者通过使用(加权)求和来将梯度分配给所有的 convex:

在一个 2D 形状合成数据集上,研究者分析了 BSP-Net 的行为。此外,他们还将 BSP-Net 与其他 SOTA 方法进行了比较,以评估该研究中的自编码器以及单视图重建效果。为了说明 BSP-Net 效果如何,研究者构建了一个 2D 合成数据集。他们在几个 64 × 64 的图像上分别放置了一个菱形、一个十字以及一个空心菱形,如图 4(a)所示。这三种形状是有顺序的,菱形总是在左边,空心菱形总是在右边,这是为了模仿 ShapeNet 等形状数据集的结构。在第一阶段的训练之后,该研究的网络已经实现了良好的近似 S^+ 重建,但是,通过查看 S^?,研究者发现他们推断的输出还存在一些缺点。在第二阶段进行了调整之后,该研究的网络实现了近乎完美的重构。最后,使用 overlap 损失显著提高了表示的紧凑性,减少了每部分的 convex 数量,如图 4(d)所示。

图 4:在 2D 合成数据集上的评估——自编码器是在合成的 2D 数据集上训练的。研究者展示了自编码结果,并用红色圈出了第一阶段中存在的错误,这些错误在第二阶段已改正。此外,研究者还展示了使用 overlap 损失的效果。注意,在可视化时,使用了不同的颜色来表示不同的 convex。

对于 3D 形状的自编码,研究者将 BSP-Net 与其他一些 shape decomposition 网络进行了比较,包括 Volumetric Primitives(VP)、Super Quadrics(SQ)以及 Branched Auto Encoders(BAE)。

BSP-Net 在保证高分割准确度的同时,也能显著提高重构质量,如表 1 和图 7 所示。

表 1:各个模型的表面重构质量和 3D 形状自编码结果对比。

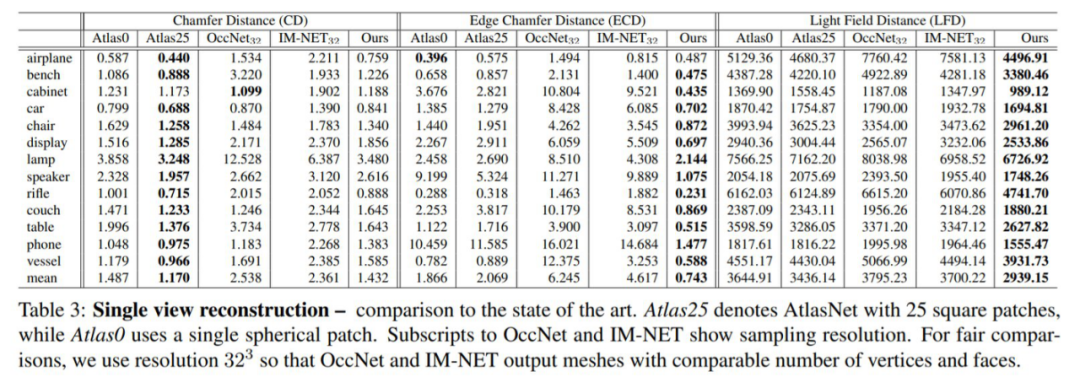

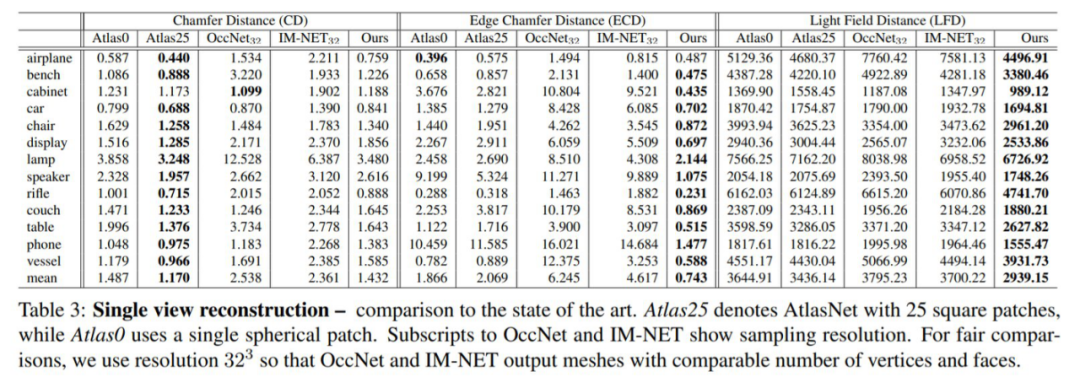

在单视图重建任务上,研究者将 BSP-Net 与 AtlasNet、IMNET 和 OccNet 做了比较,表 3 和表 4 中给出了定量分析结果,在图 8 中给出了定性结果。

表 4:low-poly 分析——单视图重建中的数据集平均指标。

图 8:单视图 3D 重建,该模型与 AtlasNet [16]、IM-NET [5]及 OccNet [28]的比较结果。WAIC 2020 黑客马拉松由世界人工智能大会组委会主办,张江集团、优必选科技、软银集团旗下软银机器人、Watson Build 创新中心、机器之心联合承办,受到新冠疫情的影响,比赛将于 7 月 8 日?- 11 日期间以远程和小规模线下结合的方式举办,招募全球顶级开发者同台竞技。

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

获取平面参数 P_{px4},其中 p 是平面的数量,即

获取平面参数 P_{px4},其中 p 是平面的数量,即 。

。 ,乘积

,乘积 ?是该点到每个平面的符号距离的向量。如果点 X 在内部,则第 i 个距离为负值,反之为正值。

?是该点到每个平面的符号距离的向量。如果点 X 在内部,则第 i 个距离为负值,反之为正值。

关注网络尖刀微信公众号

关注网络尖刀微信公众号

![戴戴子Daisy:有时间私信 不如先从点关注点赞做起[doge]](https://imgs.knowsafe.com:8087/img/aideep/2021/7/25/4c54724195c079e5f200c79a06014636.jpg?w=250)

机器之心

机器之心